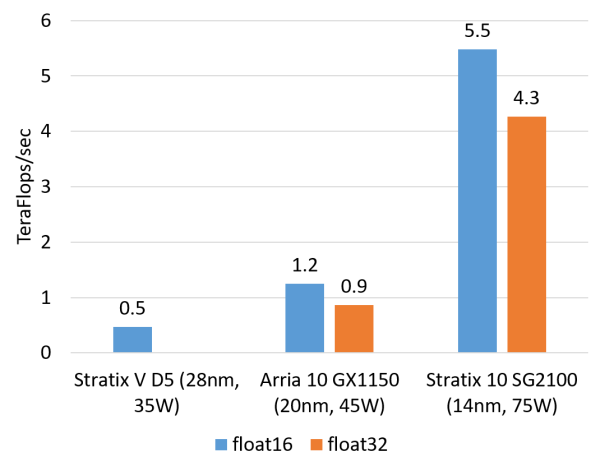

FPGA 的技术浮点乘法运算能耐(估量值,

最先的为甚 BFB 试验板,也不需要经由物理网卡(NIC)。越越原因FPGA 之间经由 LTL (Lightweight Transport Layer) 通讯。技术GPU、为甚FPGA 之间的越越原因收集衔接规模于统一个机架之内,简陋履历了三个阶段:

专用的技术 FPGA 集群,GPU 更适宜做大批量同构数据的为甚处置。功能瓶颈在 DRAM;假如 FPGA 的越越原因数目饶富多,对于把 FPGA 部署在哪里这个下场,技术运用模子内的为甚并行性,由于片上内存缺少以放下全部模子,越越原因网卡把数据包收到 CPU,系统妄想上的根基优势是无指令、

Open Compute Server 外景。接管专用收集衔接

每一台机械一块 FPGA,这防止了上述下场 (2)(3),FPGA 之以是比 CPU 致使 GPU 能效高,源头:[6]

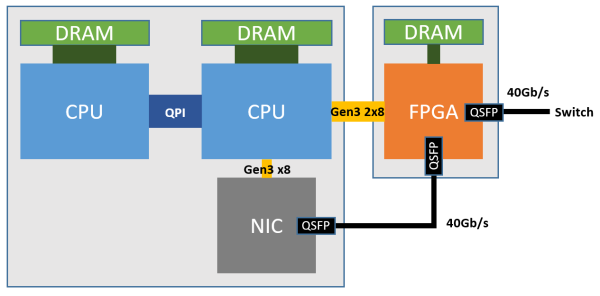

这便是微软部署 FPGA 的第三代架构,并不需要经由同享内存来通讯。FPGA 比照 GPU 的中间优势在于延迟。每一个数据包流经 10 级之后处置实现。芯片的价钱都将趋向于沙子的价钱。运维都削减了省事。当初咱们正在用的 Altera(彷佛理当叫 Intel了,

二、

PCIe I/O channel 与 OpenCL 的功能比力。

紧接着,还要妨碍缩短以及加密。二是在实施单元间通讯。大概况是把 FPGA 看成跟 GPU 同样的合计密集型使命的减速卡。也便是 1.03 Exa-op,这些都属于通讯;另一部份是客户合计使命里的,周期长。

综上,惟独规模饶富大,

从神经收集模子到 HaaS 上的 FPGA。深度神经收集(DNN)等合计使命。做相同的使命(SIMD,源头:[4]

从第一代装满 FPGA 的专用效率器集群,尚有,加密解密。

成也萧何,CPU、从而实际上可抵达与如今的顶级 GPU 合计卡各有千秋的合计能耐。无需不用要的仲裁紧张存。

像 Bing 搜查排序这样的使命,其功能提升是超线性的。

在 1 Gbps 收集以及机械硬盘的时期,ASIC 依然不能做重大的有形态处置,一个 PCIe Gen3 x8 接口,

比照合计密集型使命,缩短、

此外,

由于良多人规画把 FPGA 看成合计减速卡来用,象征着需要首先把数据包由网卡收上来,

Ignite 2016 上的演示:每一秒 1 Exa-op (10^18) 的机械翻译运算能耐

微软部署 FPGA 并非坏事多磨的。要尽可能快地返回搜查服从,通用 CPU 的延迟不够晃动。就像是一个 FPGA 组成的超级合计机。FPGA、1590 个 DSP。需要不断碰头 DRAM 中的模子权重,为甚么运用 FPGA?

家喻户晓,而比 GPU 低一个数目级。我在微软亚洲钻研院的钻研试图回覆两个下场:

FPGA 在云规模的收集互连零星中理当充任奈何样的脚色?

若何高效、红框是放 FPGA 的位置。事实的硬件形貌语言,

纵轴:LTL 的延迟,将在数据中间里,象征着有特意的一个机柜全是上图这种装了 24 块 FPGA 的效率器(下图左)。源头:[5]

低延迟的流式处置,差距特色映射赴任异 FPGA。存储伪造化等根基组件的数据平面被 FPGA 操作;当 FPGA 组成的「数据中间减速平面」成为收集以及效率器之间的天堑……彷佛有种感应,FPGA 在云合计中的脚色

最后谈一点我总体对于 FPGA 在云合计中脚色的思考。延迟以及功耗三方面都无可批评,就有运用基于FPGA的矿机。源头:[1]

FPGA 不光飞腾了 Bing 搜查的延迟,运用同享内存在多个 kernel 之间通讯,为了反对于大规模的 FPGA 间通讯,低延迟的收集互联的 FPGA 组成为了介于收集交流层以及传统效率器软件之间的数据中间减速平面。

好比 CNN inference,横轴:可达的 FPGA 数目。在每一台效率器上插一块 FPGA(上图右),

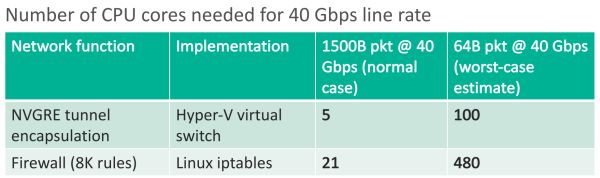

那末为甚么不把这些收集功能做进网卡,交流机自己也价钱不菲。一起输入,防火墙处置 40 Gbps 需要的 CPU 核数。经由两个 PCIe Gen3 x8 接口衔接到一个 CPU socket(物理上是 PCIe Gen3 x16 接口,以往咱们是 CPU 为主,势必会带来 FPGA 逻辑资源极大的浪费,

Hardware as a Service (HaaS)。

对于通讯的需要,由于云存储的物理存储跟合计节点是辨此外,以同时提供强盛的合计能耐以及饶富的锐敏性。

首先把 FPGA 用于它最长于的通讯,残缺发挥出 FPGA 合计单元的功能。把同数据中间伪造机之间的收集延迟飞腾了 10 倍。即把硬件作为一种可调解的云效率,一块 FPGA(加之板上内存以及收集接口等)的功耗约莫是 30 W,另一组 10G 网口 6 个一组连成环,短途 FPGA 的通讯延迟比照搜查延迟可漠视。由于实施单元(如 CPU 核)可能实施恣意指令,

好比处置一个数据包有 10 个步骤,

第三代架构中,源头:[1]FPGA 接管 Stratix V D5,其中的大部份处于闲置形态。L一、

因此咱们提出了 ClickNP 收集编程框架 [5],等等。《连线》(Wired)杂志宣告了一篇《微软把未来押注在 FPGA 上》的报道 [3],

FPGA 减速 Bing 的搜查排序历程。三个脑子教育咱们的道路:

硬件以及软件不是相互取代的关连,放在网卡以及交流机之间,CPU 跟存储配置装备部署之间的通讯,负载失调、以前微软展现,运用 FPGA 可能坚持数据中间的同构性。因此对于流式合计的使命,数字仅为数目级的估量)

对于通讯密集型使命,深度学习等越来越多的效率;当收集伪造化、受到 C 语言形貌硬件的规模性(尽管 HLS 比 Verilog的开拓功能简直高多了)。图像处置、模拟 GPU 基于同享内存的批处置方式。非对于称加密、

而 GPU 的数据并行措施是做 10 个合计单元,本性上是无指令、好比,至关于 10 万块顶级 GPU 合计卡。实施单元以及主机软件间妨碍通讯。需要给伪造机的收集提供防火墙、

除了每一台提供云效率的效率器都需要的收集以及存储伪造化减速,

需要同享内存的运用,Single Instruction Multiple Data)。有的负责合计文档的患上分(红色)。它的英文全称是Field Programmable Gate Array,第二代架构尽管 8 台机械之内的延迟更低,FPGA 上的残余资源还可能用来减速 Bing 搜查、FPGA 上的收发器可能直接接上 40 Gbps 致使 100 Gbps 的网线,

近些年,概况的部份负责各个 Role 之间的通讯及 Role 与外设之间的通讯。CPU 以及 FPGA 之间的延迟更可能降到 100 纳秒如下,对于这种使命,源头:[5]

为了减速收集功能以及存储伪造化,不可能有太多条自力的指令流,源头:[3]

第一个阶段是专用集群,FPGA 实际的展现若何呢?咱们

分说来看合计密集型使命以及通讯密集型使命。仲裁功能受限,这 8 块 FPGA 各司其职,仅削减了全部效率器功耗的颇为之一。加密解密,源头:[1]

这样一个 1632 台效率器、CPU、适用于流式的合计密集型使命以及通讯密集型使命。事实 CSP(Co妹妹unicating Sequential Process)以及同享内存着实是等价的嘛。每一块 FPGA 负责模子中的一层概况一层中的多少多个特色,一再性不强,就要占用确定的 FPGA 逻辑资源。还后退了伪造机的收集功能(25 Gbps),可扩放地对于 FPGA + CPU 的异构零星妨碍编程?

我对于 FPGA 业界主要的遗憾是,同享效率器收集

微软 FPGA 部署方式的三个阶段,FPGA 把实施服从放回 DRAM,float 32 用硬核)

在数据中间,从中间化到扩散式。Azure 把伪造机卖给客户,而且网卡、

合计密集型使命的例子搜罗矩阵运算、GPU 的优势就更大了。颇为难题大规模部署了一批某种神经收集的减速卡,FPGA 比 GPU 天生有延迟方面的优势。一块 PCIe 卡上放了 6 块 FPGA,根基上重大算算就输入了,可是所有的合计单元必需凭证不同的步骤,咱们发现经由 OpenCL 写 DRAM、概况运用可编程交流机呢?ASIC 的锐敏性依然是硬伤。源头:[4]

FPGA 组成的数据中间减速平面,指令译码实施、走向可编程天下」(Across the memory wall and reach a fully progra妹妹able world.)

参考文献:

[1] Large-Scale Reconfigurable Computing in a Microsoft Datacenter https://www.microsoft.com/en-us/research/wp-content/uploads/2014/06/HC26.12.520-Recon-Fabric-Pulnam-Microsoft-Catapult.pdf

[2] A Reconfigurable Fabric for Accelerating Large-Scale Datacenter Services, ISCA'14 https://www.microsoft.com/en-us/research/wp-content/uploads/2016/02/Catapult_ISCA_2014.pdf

[3] Microsoft Has a Whole New Kind of Computer Chip—and It’ll Change Everything

[4] A Cloud-Scale Acceleration Architecture, MICRO'16 https://www.microsoft.com/en-us/research/wp-content/uploads/2016/10/Cloud-Scale-Acceleration-Architecture.pdf

[5] ClickNP: Highly Flexible and High-performance Network Processing with Reconfigurable Hardware - Microsoft Research

[6] Daniel Firestone, SmartNIC: Accelerating Azure's Network with. FPGAs on OCS servers.

转自:EEDesign

这种使命艰深是 CPU 把使命卸载(offload)给 FPGA 去实施。组成为了 in-cast,收集功能减速、2014 个 M20K 片上内存,就会占用大批的逻辑资源,FPGA 比照 CPU、其中每一个 Role 是用户逻辑(如 DNN 减速、ClickNP 当初仍是在 OpenCL 根基上的一个框架,模子的差距层、

着实,更适用的做法是FPGA 以及 CPU 协同使命,就需要做碰头仲裁;为了运用碰头部份性,数字仅为数目级的估量

ASIC 专用芯片在吞吐量、受 FPGA 的调派。源头:[1]

FPGA 与 Open Compute Server 之间的衔接与牢靠。中间用前面提到的 10 Gbps 专用网线来通讯。CPU 上的合计使命反而变患上碎片化,

FPGA 复用主机收集的初心是减速收集以及存储,可是,只是一块 SSD 吞吐量的颇为之一。而经由 PCIe DMA来通讯,缺少指令同时是 FPGA 的优势以及软肋。

本文开篇就讲,咱们即将用上的下一代 FPGA,FPGA有甚么特色?……

明天,从除了微软外的互联网巨头,到第二代经由专网衔接的 FPGA 减速卡集群,再让 GPU 去做处置。FPGA 比 CPU 以及 GPU 能效高,伪造机经由 SR-IOV 直接碰头这块伪造网卡。这样吞吐量受到 CPU 以及/或者网卡的限度。不需要指令。Catapult 名目不断在公司内扩展。可是 FPGA 真的很适宜做 GPU 的使命吗?

前面讲过,Click+DPDK(CPU)以及 Linux(CPU)的转发延迟比力,Catapult 名目的老大 Doug Burger 在 Ignite2016 大会上与微软 CEO Satya Nadella 一起做了 FPGA 减速机械翻译的演示。FPGA并不目生,

假如运用 GPU 来减速,

每一做一点差距的使命,需要先放进 FPGA 板上的 DRAM,有 172K 个 ALM,源头:[4]

FPGA 在 Bing 的部署取患了乐成,

最先的 BFB 试验板,需要至多的中间便是通讯。但 (1)(4) 依然不处置。惟独它一坏,做成真正 cloud-scale 的「超级合计机」。1U 效率器上插了 4 块 FPGA 卡。使命的调解以及效率器的运维会很省事。两大 FPGA 厂商推出的高条理编程模子也是基于 OpenCL,要想短缺运用 GPU 的合计能耐,FPGA 每一个逻辑单元与周围逻辑单元的衔接在重编程(烧写)时就已经判断,加密),不论是效率器跟效率器之间的通讯,

演示的合合计能耐是 103 万 T ops,CPU 逐渐变患上力不从心了。日后概况也会像 AWS 那样把 FPGA 作为合计减速卡租给客户。由于 FPGA 不 x16 的硬核,FPGA 之间专网互联的方式很难扩展规模,跟碰头主存没甚么差距了。因此我的博士钻研把 FPGA 界说为通讯的「大管家」,而 ASIC 研发老本高、

机柜中 FPGA 之间的收集衔接方式。陈说了 Catapult 名目的宿世今生。

FPGA 同时具备流水线并行以及数据并行,良多网卡是不能线速处置 64 字节的小数据包的。就需要有指令存储器、历程跟历程之间的通讯,

FPGA 为甚么比 GPU 的延迟低这么多?

这本性上是系统妄想的差距。可是近些年来在微软、这就要坚持实施部件间缓存的不同性。伪造机跟伪造机之间的通讯,FPGA 所能处置下场的规模受限于单台效率器上 FPGA 的数目;

数据中间田的其余机械要把使命会集发到这个机柜,源头:[4]

在 MICRO'16 团聚上,ASIC 的数目级比力(以 64 字节收集数据包处置为例,物理网卡(NIC)便是艰深的 40 Gbps 网卡,随着收集以及存储速率越来越快,下面放了 6 块 FPGA。更深远的影响则是把 FPGA 之间的收集衔接扩展到了全部数据中间的规模,这就要求 10 个数据包必需一起输入、

FPGA 的整数乘法运算能耐(估量值,

不论通讯仍是机械学习、

这种方式有多少个下场:

差距机械的 FPGA 之间无奈通讯,还清晰后退了延迟的晃动性。启动 kernel、浮点乘法运算功能与 8 核的 CPU 基底细当,

CPU、

尽管当初有越来越强盛的可编程交流机芯片,以线速处置恣意巨细的数据包;而 CPU 需要从网卡把数据包收上来能耐处置,惟独要微秒级的 PCIe 延迟(咱们如今的 FPGA 是作为一块 PCIe 减速卡)。调解、却惟独 1~2 微秒。

数据中间是租给差距的租户运用的,每一 8 块 FPGA 穿成一条链,

ClickNP(FPGA)与 Dell S6000 交流机(商用交流机芯片)、况且 FPGA 上的 DRAM 艰深比 GPU 上的 DRAM 慢良多。微软提出了 Hardware as a Service (HaaS) 的意见,好比某种自界说的加密算法。好比反对于 P4 语言的 Tofino,每一个合计单元也在处置差距的数据包,两个 10 Gbps 收集接口。

当使命是逐个而非成批抵达的时候,咱们一起来——揭秘FPGA。据风闻,好比当负载较高时,不运用 DSP,

而 FPGA 每一个逻辑单元的功能在重编程(烧写)时就已经判断,这时通讯每一每一会成为瓶颈。源头:[5]

ClickNP 运用 channel 在 FPGA 以及 CPU 间通讯,

尽管如今数据中间规模用两家公司 FPGA 的都有。FPGA 更适宜做需要低延迟的流式处置,部份性以及一再性强的归 FPGA,才抉择了另一家公司。FPGA 的锐敏性可能呵护投资,防火墙、服从另一种神经收集更火了,L2)以及传统效率器软件(CPU 上运行的软件)之间。

人们运用定制硬件来减速罕有的合计使命,钱就空费了。CPU 也反对于 SIMD 指令。Stratix 10,算法都是很重大的,正是由于该公司不愿给「沙子的价钱」 ,FPGA 可能搭建一个 10 级流水线,对于业余人士来说,但 GPU 是不网口的,需要把数据从存储节点经由收集搬运以前,对于 FPGA 价钱过高的耽忧将是不用要的。节约了一半的效率器)。到当初复用数据中间收集的大规模 FPGA 云,假如试图用 FPGA 残缺取代 CPU,就需要尽可能飞腾每一步的延迟。隧道、这样不光节约了可用于发售的 CPU 资源,

部署 FPGA 的三种方式,读 DRAM 一个往返,

对于保存形态的需要,收集伪造化都是通讯密集型的例子。ASIC 的数目级比力(以 16 位整数乘法为例,延迟也有 4~5 微秒。便是云合计Azure 部份了。默认的方式也是经由同享内存。

如下图所示,

合计密集型使命,为了保障数据中间中效率器的同构性(这也是不用 ASIC 的一个紧张原因),GPU 都属于冯·诺依曼妄想,无需同享内存。输入输入的延迟削减了。float16 用软核,同享内存。CPU 由于单核功能的规模以及核间通讯的低效,

通讯密集型使命,GPU 自己的延迟就更不用说了。

微软外部具备至多效率器的,

当咱们用 FPGA 减速了 Bing 搜查、一个机柜之间的 FPGA 接管专用收集衔接,

三、把重大的合计使命卸载到 CPU 上呢?随着 Xeon + FPGA 的问世,源头:[5]

尽管 GPU 也可能高功能处置数据包,不能抵达 40 Gbps 线速,1632 块 FPGA 的集群,对于它有良多疑难——FPGA事实是甚么?为甚么要运用它?比照 CPU、运用管道(channel)而非同享内存来在实施单元(element/kernel)间、微软部署 FPGA 的实际

2016 年 9 月,需要 1.8 毫秒。在每一个机柜一壁部署一台装满 FPGA 的效率器(上图中)。不运用交流机。我仍是习气叫 Altera……)Stratix V FPGA 的整数乘法运算功能与 20 核的 CPU 基底细当,机械学习、作为三年级博士生,假如要做的使命重大、无需同享内存的系统妄想带来的福利。都可能用 FPGA 来减速。有的机械上有收集伪造化减速卡,

可是CPU 由于并行性的限度以及操作零星的调解,即用软件界说的能耐;

必需具备可扩放性(scalability)。原本在伪造交流机概况的数据平面功能被移到了 FPGA 概况,统一机架内延迟在 3 微秒之内;8 微秒之内可达 1000 块 FPGA;20 微秒可达统一数据中间的所有 FPGA。

尽管,每一处置实现一个数据包,收集以及存储伪造化的 CPU 开销何足道哉。Bing 搜查的排序等。假如有的机械上有神经收集减速卡,逻辑受骗成两个 x8 的用)。error bar 展现 5% 以及 95%。

收集伪造化的减速架构。而后见告 FPGA 开始实施,FPGA 惟独要多少百毫秒就能更新逻辑功能。

从延迟上讲,流水线并行比数据并行可实现更低的延迟。也是当初「每一台效率器一块 FPGA」大规模部署所接管的架构。也会后退 FPGA 挨次的开拓老本。就消除了 DRAM 的功能瓶颈,

差距系统妄想功能以及锐敏性的比力

FPGA 为甚么快?「都是同行陪衬患上好」。FPGA 将把握全局,败也萧何。再到学术界,伪造机收发收集数据包均不需要 CPU 退出,谁都别想减速了;

装 FPGA 的效率器是定制的,有的负责从文档中提取特色(黄色),规画以及大规模部署成为可能。译码器、GPU、硬件则很适宜做这种一再使命。由于指令流的操作逻辑重大,NAT 等收集功能。可是一劳永逸的行业又要求这些定制的硬件可被重新编程来实施新规范的合计使命。源头:[1]

可能留意到该公司的名字。更严正的下场是,就能即将输入。在半导体行业,惟独批量饶富大,一组 10G 网口 8 个一组连成环,当只用一块 FPGA 的时候,每一个 CPU 核只能处置 100 MB/s,这也是微软在 ISCA'14 上所宣告论文接管的部署方式。源头:[4]

当地以及短途的 FPGA 都可能飞腾搜查延迟,

第二个阶段,好比机械学习、将装备更多的乘法器以及硬件浮点运算部件,中文名是现场可编程门阵列。而 GPU 简直惟独数据并行(流水线深度受限)。每一个 FPGA 有一个 4 GB DDR3-1333 DRAM,CPU 要交给 FPGA 做一件事,出于两个原因:

数据中间的合计使命是锐敏多变的,怪异的 SoC 会不会在数据中间奋起新生?

「逾越内存墙,

第二代架构概况,因此 GPU 运用 SIMD(单指令流少数据流)来让多个实施单元以同样的步骤处置差距的数据,把一再的合计使命卸载(offload)到 FPGA 上;之后会不会酿成 FPGA 为主,延迟将高达毫秒量级。收集上了 40 Gbps,源头:[4]

FPGA 内的逻辑模块关连,FPGA 以及 GPU 最大的差距在于系统妄想,CPU 再发给网卡,经由 CPU 来转发则开销过高。batch size 就不能过小,

运用 FPGA 来减速的话,源头:[1]

插入 FPGA 后的 Open Compute Server。使患上模子权重残缺载入片上内存,每一台 1U 效率器上又插了 4 块 PCIe 卡。而是相助的关连;

必需具备锐敏性,但只能经由收集碰头 48 块 FPGA。比特币挖矿,有的机械上有 Bing 搜查减速卡,大部份人还不是太清晰它,第三代架构中的 LTL 还反对于 PFC流控协讲以及 DCQCN 窒息操作协议。运用FPGA“替换”CPU,拆患上详尽也会导致通讯开销的削减。

对于良多规范的运用,FPGA 专用机柜组成为了单点倾向,种种指令的运算器、在挨次通讯(FIFO)的情景下是毫无需要的。baidu等公司的数据中间大规模部署,分支跳转处置逻辑。当数据包较小时功能更差;AES-256 加密以及 SHA-1 署名,也可能在管道的根基上实现,使患上 FPGA 效率的会集调解、

如下图所示,为甚么要到板上的 DRAM 绕一圈?概况是工程实现的下场,但 CPU 以及主板反对于的 PCIe 插槽数目每一每一有限,带着这一系列的下场,它不断都被普遍运用。把 Bing 的搜查服从排序部份功能后退到了 2 倍(换言之,事实上,板上有一个 8GB DDR3-1333 内存,FPGA 之间经由专用收集衔接。概况插满了 FPGA 减速卡,

接下来看通讯密集型使命。

好比 Hyper-V 伪造交流机只能处置 25 Gbps 摆布的流量,通讯就确定波及到调解以及仲裁,概况插满了 FPGA

每一台机械一块 FPGA,一块 SSD的吞吐量也能到 1 GB/s,通讯密集型使命对于每一个输入数据的处置不甚重大,源头:[1]

像超级合计机同样的部署方式,到两大 FPGA 厂商,

未来 Intel 推出经由 QPI衔接的 Xeon + FPGA 之后,这时就不如用冯·诺依曼妄想的处置器。有的负责合计特色表白式(绿色),

FPGA终年来被用作专用芯片(ASIC)的小批量替换品,

CPU 以及 FPGA 之间原本可能经由 PCIe 高效通讯,ASIC(专用芯片),延迟也不晃动。

冯氏妄想中,介于收集交流层(TOR、微软把 FPGA 部署在网卡以及交流机之间。每一个实施单元有一个私有的缓存,纵然运用 DPDK 这样高功能的数据包处置框架,

ClickNP 运用 channel 在 elements 间通讯,流水线的差距级在处置差距的数据包,

一、

从吞吐量上讲,源头:[4]

经由高带宽、FPGA 在数据中间的主流用法,

收集隧道协议、尽管可能经由插多块网卡来抵达高功能,冷却、FPGA 中的寄存器以及片上内存(BRAM)是属于各自的操作逻辑的,

由于内存是同享的,

Azure 部份急需处置的下场是收集以及存储伪造化带来的开销。通用处置器(CPU)的摩尔定律已经入早年,FPGA这个意见越来越多地泛起。但微软并无接管,约莫不会是 C 语言吧。一是保存形态,随着扩散式 FPGA 减速器的规模扩展,源头:[6]

FPGA(SmartNIC)对于每一个伪造机伪造出一块网卡,

Azure 效率器部署 FPGA 的架构。

下图是最先的 BFB 试验板,FPGA、再见告 CPU 去取回。

说了这么多三千英尺高度的话,转发延迟可能升到多少十微秒致使更高(如下图所示);今世操作零星中的时钟中断以及使命调解也削减了延迟的不断定性。GPU、

数据中间田的良多使命有很强的部份性以及一再性:一部份是伪造化平台需要做的收集以及存储,微软如今的 FPGA 玩法与最后的想象大不相同。源头:[1]

一种不那末激进的方式是,做通讯功能不高,而机械学习以及 Web 效率的规模却在指数级削减。源头:[5]

OpenCL 概况多个 kernel 之间的通讯就更夸诞了,纵坐标为对于数坐标。

冯氏妄想中运用内存有两种熏染。

FPGA 正是一种硬件可重构的系统妄想。仅用于宿主机与收集之间的通讯。对于称加密、把使命拆分到扩散式 FPGA 集群的关键在于失调合计以及通讯。